La ciberdelincuencia es un gran problema. Sin embargo, hay que reconocer que la inventiva y la capacidad de innovar que demuestran los hackers es digna de elogio. Cuando creemos que ya tenemos todo controlado, surgen nuevas amenazas, más sofisticadas, peligrosas y difíciles de detectar.

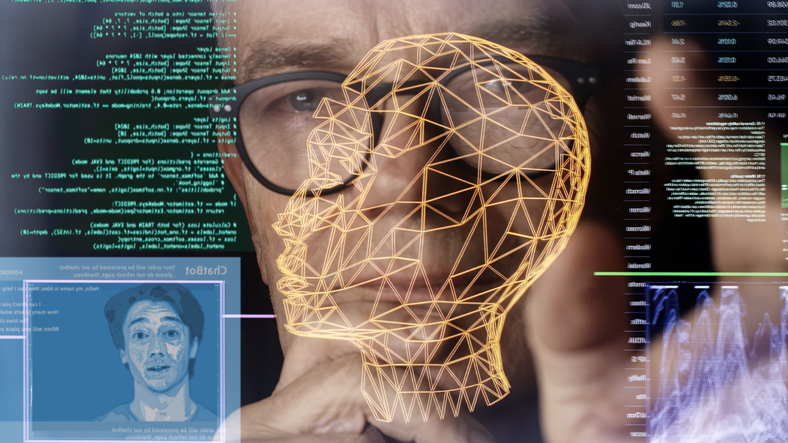

Por ejemplo, Unit 42, unidad de ciberinteligencia de Palo Alto Networks, advierte que los ciberdelincuentes pueden usan identidades falsas creadas mediante deepfakes en tiempo real con las que realizan entrevistas laborales para colarse en aquellas empresas e instituciones que se fijen como objetivo

Según explica la compañía de ciberseguridad, se trata de una técnica que ya está siendo utilizada por trabajadores del sector TI vinculados al régimen de Corea del Norte en campañas de infiltración remota en empresas internacionales.

De hecho, The Register informaba hace algunos meses de que el FBI había detectado intentos de infiltración de origen norcoreano, utilizando IA generativa para desarrollar lotes masivos de perfiles y solicitudes de LinkedIn para trabajos remotos en empresas occidentales.

Sin embargo, cuando contactaban para realizar una entrevista a través de videoconferencia con un candidato en Polonia, por ejemplo, se encontraban con un hombre asiático en edad militar.

Así pues, la creación de identidades sintéticas en tiempo real mediante deepfakes supone un enorme paso adelante, ya que los hackers ahora pueden esconder su verdadero rostro tras esta capa de IA.

Y si consiguen infiltrarse en la empresa, nos encontraremos con un ‘caballo de Troya’, ya que dispondrán de unas credenciales que les darán acceso a los sistemas de la compañía, a sus bases de datos, a su propiedad intelectual…

Por eso, aun cuando se trate de candidatos reales y sin malas intenciones, siempre conviene extremar las precauciones cuando se incorpora un nuevo empleado, ya que los tres primeros meses desde su llegada son críticos, como contábamos en este artículo.

Deepfakes al alcance de cualquiera

Para demostrar lo fácil que es crear una identidad falsa, un analista de Unit 42 sin experiencia en manipulación de imágenes y con conocimientos limitados sobre tecnología deepfake generó una identidad sintética funcional en apenas 70 minutos, empleando para ello un ordenador doméstico, software gratuito e imágenes generadas por IA a través de plataformas como thispersondoesnotexist.org.

Según explica la compañía de ciberseguridad, el mayor reto no fue la creación del rostro, sino configurar una cámara virtual para simular una videollamada en tiempo real.

Pero Unit 42 fue un paso más allá y encargó a sus expertos el desarrollo de una identidad sintética utilizando un equipo más potente y técnicas más avanzadas, generando un deepfake de mayor calidad y realismo.

Aunque haya sido sólo un experimento de laboratorio, la amenaza no se limita al ámbito teórico. El informe recoge casos reales, como el de una empresa tecnológica en Polonia que detectó similitudes entre dos candidatos distintos y sospechó que se trataba de la misma persona operando con identidades separadas.

También habla de entrevistas en las que los candidatos mostraban vídeos sintéticos, utilizando fondos virtuales idénticos entre distintos perfiles.

Unit 42 señala que las tácticas, técnicas y procedimientos coinciden con las usadas previamente por trabajadores TI de Corea del Norte en 2023, cuando su equipo descubrió la creación de perfiles sintéticos respaldados por datos personales robados, circunstancia que dificultaba su detección en procesos de verificación tradicionales.

¿Cómo detectar un perfil falso?

Aunque los perfiles sintéticos cada vez son más sofisticados, los expertos de Unit 42 afirman que las técnicas de deepfake en tiempo real aún presentan limitaciones que pueden servir como señales de alerta.

Así pues, apuntan algunos recursos útiles para detectar un posible engaño mediante deepfake en una entrevista en vídeo. Por ejemplo, recomiendan pedir al candidato que mueva la cabeza bruscamente, pase la mano por delante del rostro o realice expresiones faciales marcadas, ya que estos movimientos pueden generar errores visuales detectables.

También anota que nos debemos fijar en la aparición de desajustes más sutiles, como desfases entre el audio y el movimiento de los labios, problemas de iluminación en los bordes del rostro o fallos al superponer elementos como gafas o manos.

Finalmente, el informe aconseja que los departamentos de Recursos Humanos y Ciberseguridad trabajen de la mano, con el objetivo de reducir los riesgos asociados a estas suplantaciones.

En este sentido, recomienda solicitar la activación de cámara en todas las entrevistas, pidiendo consentimiento para grabar; la comprobación de documentos con herramientas de verificación; la exigencia de pruebas de vida en tiempo real, como mostrar un documento y realizar gestos específicos; el análisis de la procedencia de las IP y la detección del uso de VPN o cámaras virtuales; el establecimiento de verificaciones adicionales antes de conceder accesos sensibles; y la formación de los equipos de selección para identificar signos de manipulación facial o comportamientos sospechosos.